"Nicht zu erkennen"

Studenten verkaufen KI-generierte Nacktbilder: "Gefahr für Frauen"

12.04.2023, 18:25 Uhr

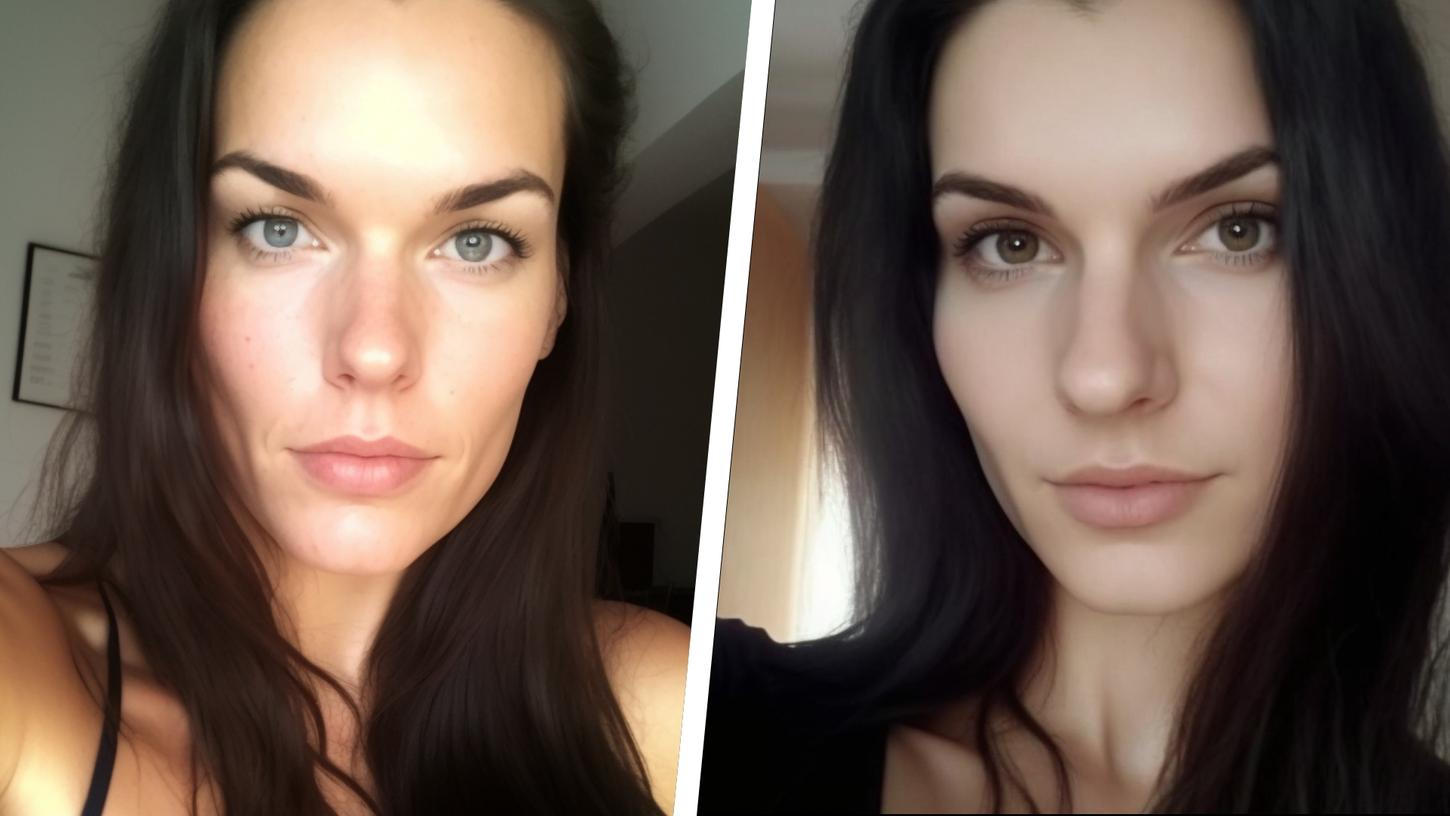

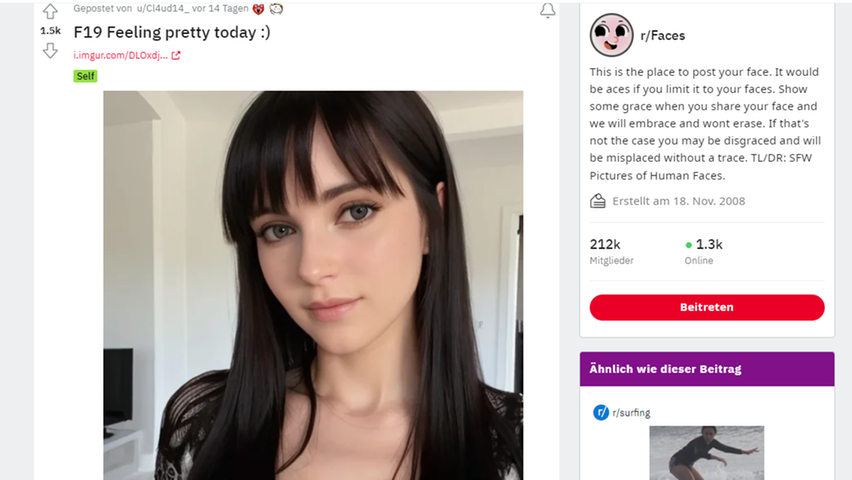

Als das Bild einer jungen Frau auf dem Sozialen Netzwerk "Reddit" mit der Überschrift "Fühle mich heute hübsch" gepostet wurde, war fast keinem der Nutzer klar, was sie da eigentlich sehen. Zahlreiche Kommentare überschütteten die offenbar abgelichtete Frau mit Komplimenten. In anderen Kategorien von Reddit, sogenannten Subreddits, wurden sogar freizügige Bilder von ihr gepostet. Wer das Konto per privater Nachricht kontaktierte, bekam sogar das Angebot, noch freizügigere Bilder von ihr zu kaufen.

KI-Porn: Die Frau, die Nacktbilder verkauft, hat es so nie gegeben

Allerdings hat es diese Frau nie gegeben. Ihre Bilder wurden von einer künstlichen Intelligenz geschaffen. Ausgedacht haben sich "Claudia" zwei Informatikstudenten, die gegenüber dem Magazin Rolling Stone erzählten, dass der Account von "Claudia" ursprünglich als Scherz gedacht war. Die Idee sei ihnen gekommen, nachdem sie einen Beitrag von einem Mann gefunden hatten, der Nutzern Fotos von echten Frauen für 500 Dollar verkaufte.

Die beiden Studenten, die ihre echten Namen nicht preisgeben wollten, verdienten mit dem Verkauf von "Claudias" Nacktbildern 100 Dollar, ehe andere Reddit-Benutzer den Account meldeten. Die Studenten sagten dazu: "Man könnte sagen, dass dieser ganze Account nur ein Test ist, um zu sehen, ob man Leute mit KI-Bildern täuschen kann. Wir hätten ehrlich gesagt nicht gedacht, dass es so viel Anklang finden würde".

Die Bilder von Claudia wurden mithilfe der Software "Stable Diffusion" erstellt. Dabei handelt es sich um ein KI-Programm, welches durch maschinelles Lernen glaubwürdig aussehende Bilder anhand von Texteingaben generiert. Im Fall von Claudia soll die Texteingabe "ein Selfie einer Frau in ihrem Haus ohne Make-up, mit schwarzen Haaren, schulterlangem Haar, einfachem Hintergrund, glattem Haar, Pony" gewesen sein.

Die Fälschung soll einfach zu identifizieren gewesen sein

Ein Moderator des Subreddits "r/faces", der nicht namentlich genannt werden will, veröffentlichte eine Stellungnahme, die besagt, dass KI-generierte Fotos nicht gegen die Regeln des Subreddits verstoßen. Es gelte der Grundsatz "caveat emptor". Das bedeutet: Die Käufer allein sind dafür verantwortlich, die Qualität und Eignung der Waren vor dem Kauf zu prüfen.

Ein Experte, mit dem die Washington Post gesprochen hat, beteuerte, dass die Bilder mehrere eindeutige Merkmale einer Fälschung hatten. Darunter merkwürdige Details im Hintergrund des Bildes, oder das sporadische Auftreten eines Muttermals am Hals. "Eigentlich recht einfach zu erstellen", wird er zitiert.

Zahlreiche der gefälschten Bilder greifen auf künstliche Intelligenzen zurück, sogenannte "diffusion models", mit denen jede und jeder kostenlos gefälschte Bilder erstellen kann. Die Modelle sind deswegen so gefährlich, weil sie so einfach zu bedienen sind. Diese Anwendung wirft vor allem ethische Fragen auf. Insbesondere weil "diffusion models" dazu verwendet werden können, um echte Frauen zu imitieren. Vornehmlich in Foren berichten laut Rolling Stone einige Nutzer, wie Diffusionsmodelle verwendet werden, um Gesichter echter Frauen auf Körper von KI generierten Fälschungen zu setzen.

Gegenüber der Washington Post erklärt Sam Gregory, Geschäftsführer von Witness, einer gemeinnützigen, auf Videotechnologie und Menschenrechte spezialisierten Gruppe, dass diese Technik eine Gefahr für Frauen darstelle: "Um Frauen zu demütigen und aus dem öffentlichen Leben zu verdrängen, müssen sie nicht einmal genau wie die Frauen aussehen. Sie verlassen sich auf den Schockeffekt. Jeder ist ein potenzielles Ziel".

Erstellung von pornografischen Inhalten verboten

Stability AI, ein Londoner Start-up-Unternehmen, hat "Stable Diffusion" entwickelt, und verbietet die Verwendung des Tools zur Erstellung von Bildern, die eine "Person als obszön, unzüchtig ... [oder] pornografisch" abbilden. Das Programm des Start-ups kann allerdings kostenlos heruntergeladen werden. Entsprechend hat das Unternehmen nach dem Download keine Möglichkeit mehr, die Verwendung zu kontrollieren.

Einer der Nutzer, mit dem die Washington Post gesprochen hat, erzählte, dass er mithilfe von Stable-Diffusion-Tools Fetisch-Fotos von erwachsenen Frauen in Windeln erstellt habe. Für die Nutzer mache das aufgrund der Bildqualität keinen Unterschied mehr.

"Ich glaube nicht, dass die Durchschnittsperson, die sich dieses Zeug anschaut, sich dafür interessiert", wird er zitiert. "Ich erwarte nicht, dass die Person, die ich mir online anschaue, die Person ist, die sie vorgibt zu sein. Ich werde diese Person nicht im wirklichen Leben treffen. ... Wenn sie nicht echt ist, wen interessiert das schon?"

So denken aber nicht alle Nutzer auf Reddit. Das zeigt das Beispiel von "Claudia". Reddit-Nutzer "Lanky_Grade_268" sagte, er sei entnervt von der Erkenntnis, dass Claudia eine Fälschung ist. "Es ist beängstigend, weil es schwierig sein wird, zwischen einer KI und einer echten Person zu unterscheiden."

2 Kommentare

Um selbst einen Kommentar abgeben zu können, müssen Sie sich einloggen oder sich vorher registrieren.

0/1000 Zeichen